comfyui老夜AI绘画

首先非常欢迎新进群的新同学!!后面是各种AI工具有很多国内外的AI,各有优缺点,配合使用。你会得到意想不到的效果!但是SD是最强大的AI绘画工具,学好SD才是我们的宗指!!电脑作为参考,需要...

comfyUI人像精修人脸精修工作流

ComfyUI换脸工作流主要通过ReActor、InstantID等插件实现,支持图片、视频及多人换脸。以下是核心要点:一、插件与模型准备ReActor插件安装:通过ComfyUI管理器搜索安装'ReActor Nodes for Comf...

Ollama、docker、chatbox、Cherry Studio、Visual Studio工具包

【免费】提供官方下载地址(比较慢),下方链接自行下载。 【收费】的是提前下载好的,购买之后有网盘链接下载。 付费内容有Ollama、docker、chatbox、Cherry Studio、VsCode、AnythingLLM、Off...

Ai画的营销微信二维码

AI生成隐藏式二维码方法:图像融合技术:AI(如GAN、卷积神经网络)将二维码的编码信息嵌入到普通图像(如插画、照片)中,通过调整颜色、纹理和图案,使二维码与背景自然融合。例如:在艺术设...

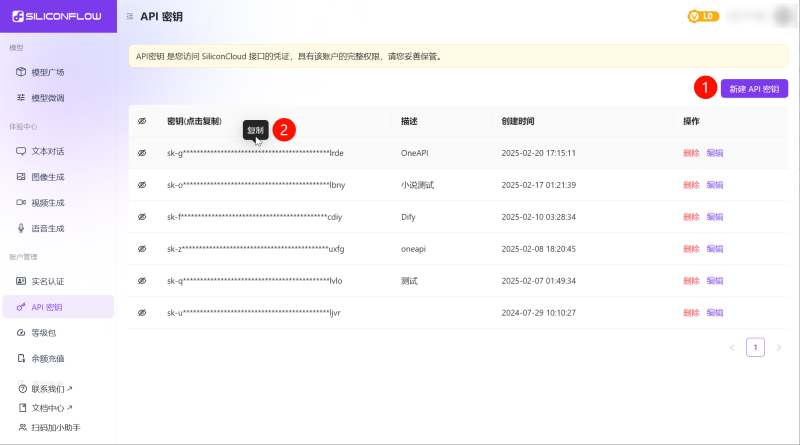

DeepSeek API 超详细使用指南 – 配套文档

本文档主要分为四部分,点击下方按钮可快速跳转AI 对话客户端DeepSeek API 合集主流大语言模型 API 合集推理模型合集AI 对话客户端 名称链接备注Cherry Studiohttps://cherry-ai.com/推荐使用,...

企业形象-讲师海报定制

企业形象构成主要包含以下六个核心维度,各维度相互关联形成价值共识体系:一、核心理念体系以企业价值观为中枢,包含使命愿景、经营哲学及文化特质,构成企业决策与发展的底层逻辑。优秀企业往...

Llama的TTSp真人发音系统文字转语音

Llama的TTSp真人发音系统文字转语音Llama的TTSp真人发音系统文字转语音Llama的TTSp真人发音系统文字转语音Llama的TTSp真人发音系统文字转语音Llama的TTSp真人发音系统文字转语音

Manus邀请码【高权重】企业邮箱

Manus 是一个通用的人工智能代理,它连接思想和行动:它不仅会思考,还会提供结果。Manus 擅长处理工作和生活中的各种任务,可以在你休息时完成所有事情。有偿提供服务,付费之后【添加技术】对...