文章目录

步骤一: 安装灵魂工具Ollama

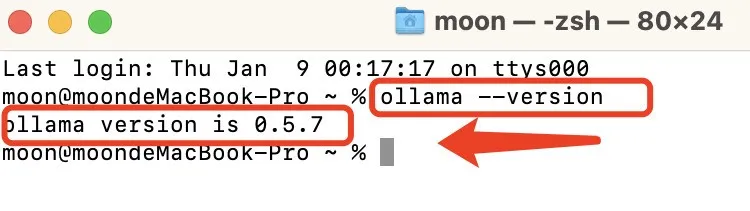

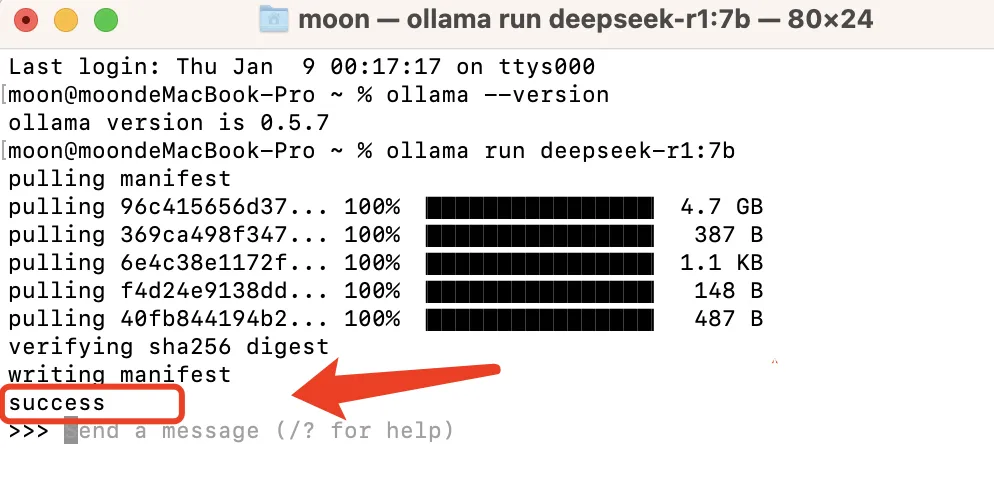

验证安装(也可忽略):安装完成后,在终端输入以下命令,检查Ollama版本:

步骤二: 下载并运行deepseek模型

步骤三: 安装可视化工具: chatbox

相信大家都感受到了,DeepSeek最近非常火,火到有时很卡顿,用不了…

那么本地部署的需求也随之而来,DeepSeek作为一款开源且性能强大的大语言模型,提供了灵活的本地部署方案,让用户能够在本地环境中高效运行模型,无需支付在线 API 费用,自由调整和定制模型参数,同时保护数据隐私。

其实很简单,几分钟就可以安装完。

步骤一: 安装灵魂工具Ollama

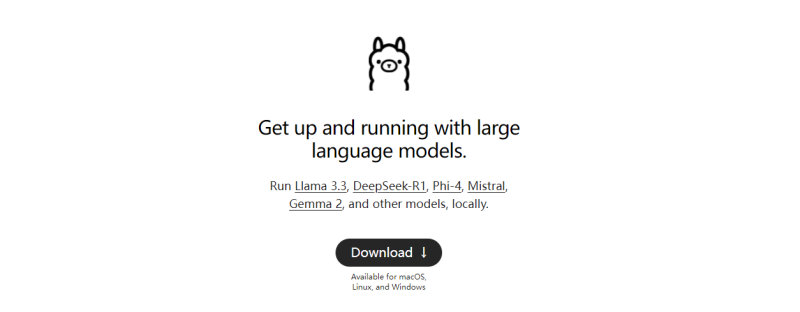

Ollama是一个开源工具,专门用于在本地计算机上运行和操作大型语言模型(LLM)。它让用户能够轻松下载、管理和运行各种 AI 模型(如 LLaMA、Mistral 等),而无需复杂的配置或依赖云服务。

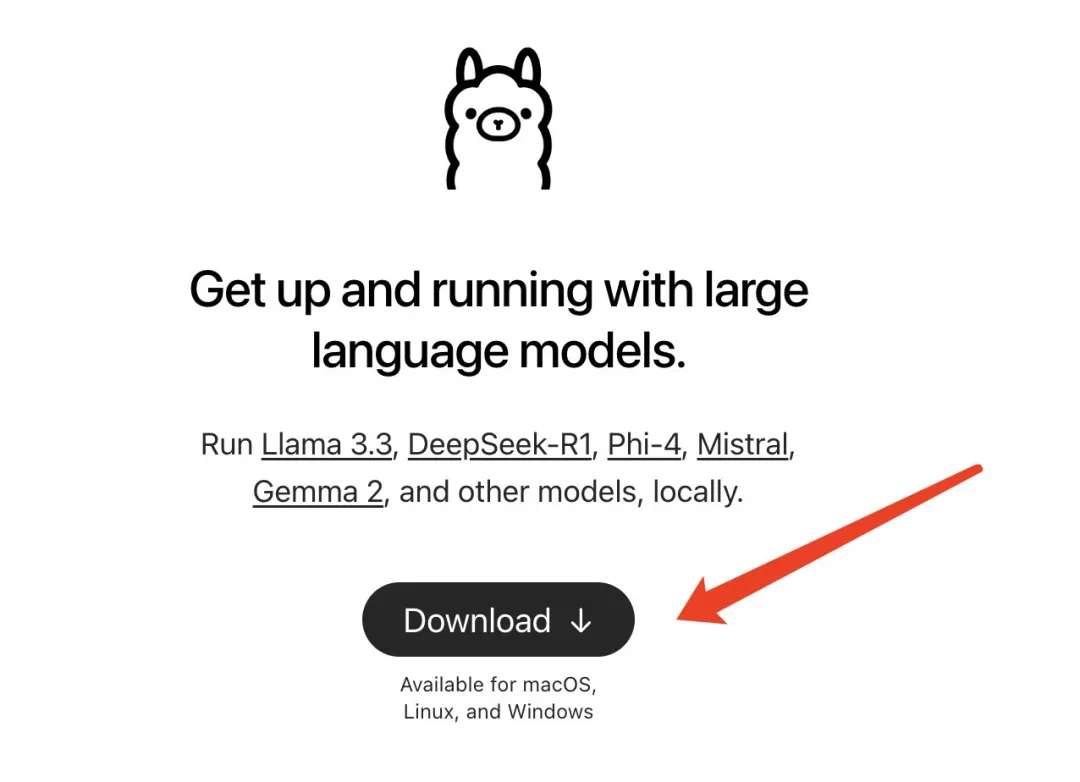

以下是安装Ollama的步骤:

官网下载直通车: https://ollama.com

前往Ollama官网,点击“Download”按钮

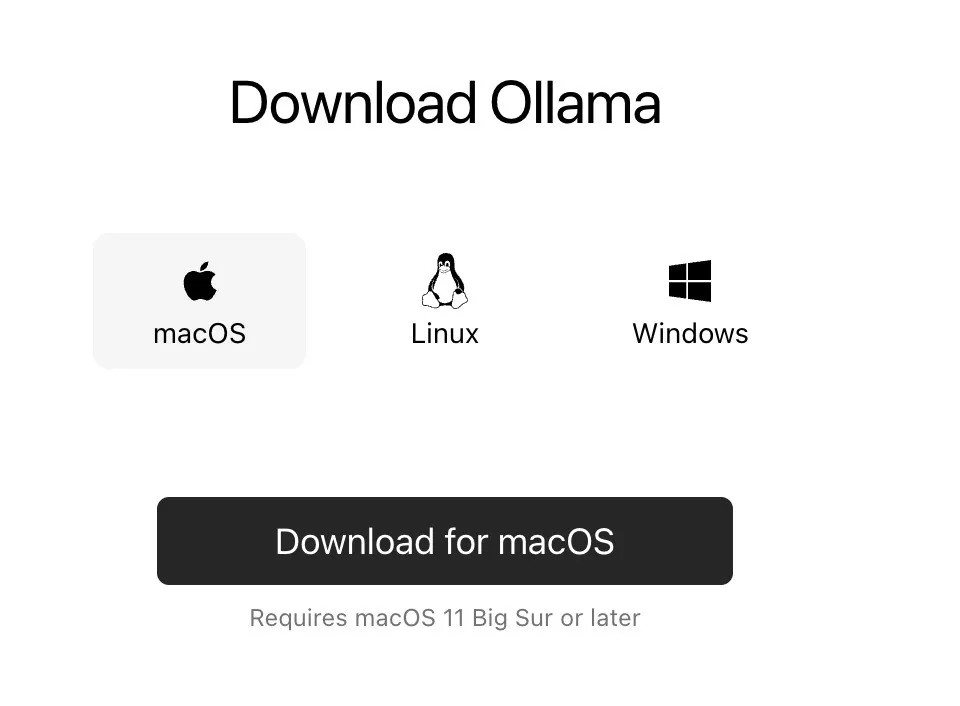

下载安装包:根据你的操作系统选择对应的安装包(本文以macOS为例演示)。下载完成后,直接双击安装文件并按照提示,一直下一步,直到完成安装。

验证安装(也可忽略):安装完成后,在终端输入以下命令,检查Ollama版本:ollama –version 如果输出版本号(例如ollama version is 0.5.7),则说明安装成功。

如果输出版本号(例如ollama version is 0.5.7),则说明安装成功。

步骤二: 下载并运行deepseek模型

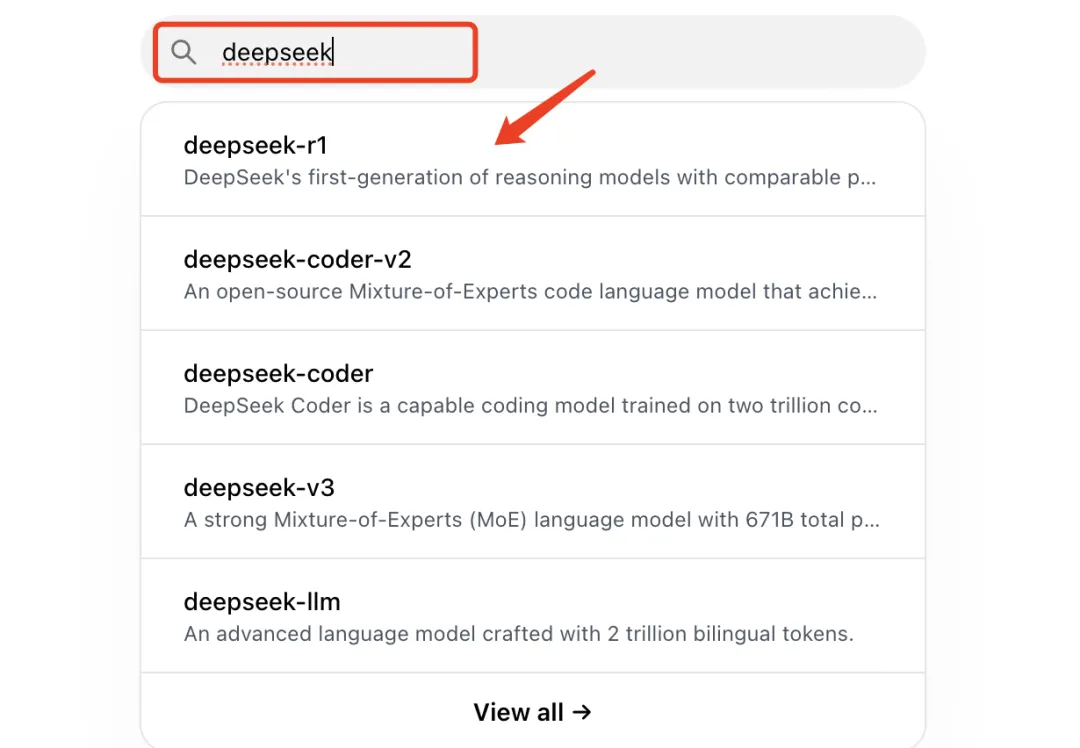

回到ollama的官网https://ollama.com,搜索框里搜索deepseek,选择要安装的deepseek-r1模型。

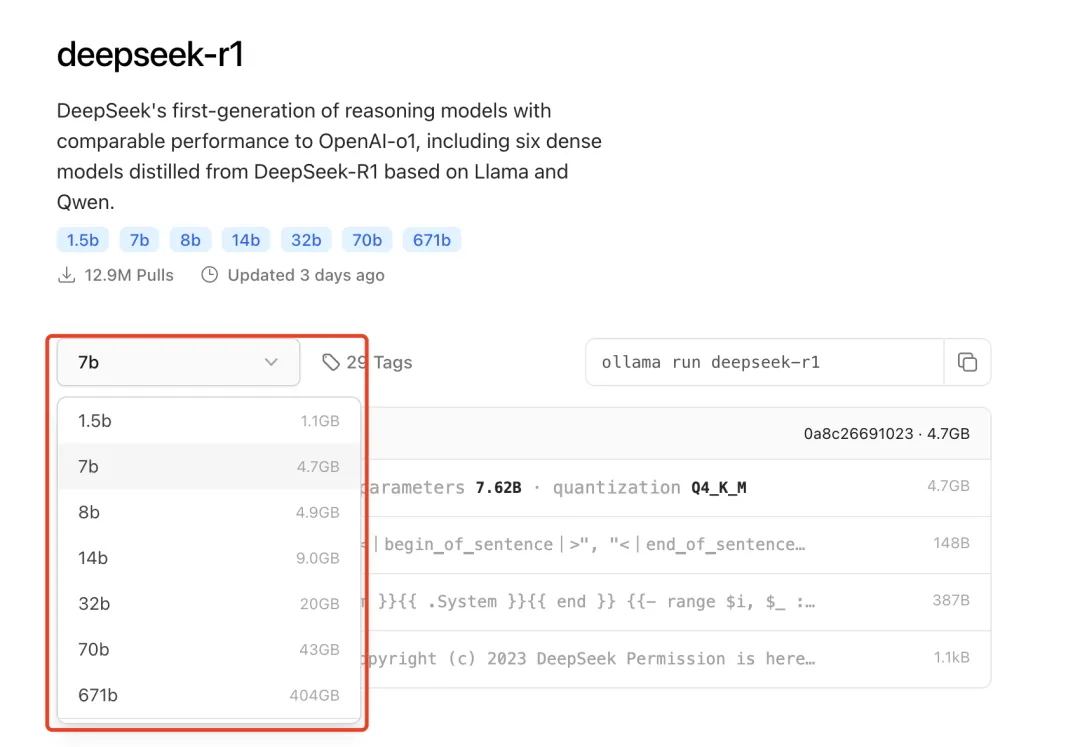

点击下拉框,可以看到多个版本,区别是参数不一样,数字越大,代表参数越多,性能就越强,但也对计算机的性能要求较高。

模型版本怎么选?电脑配置不行的,建议选择1.5B版本,这个模型有15亿参数,属于最轻量的Deepseek版本。但是1.5b模型数量不够,有点不够智能。所以电脑配置好点的,可以选择7以上的。不过还是自己电脑带得动的才是最合适的,不用纠结。

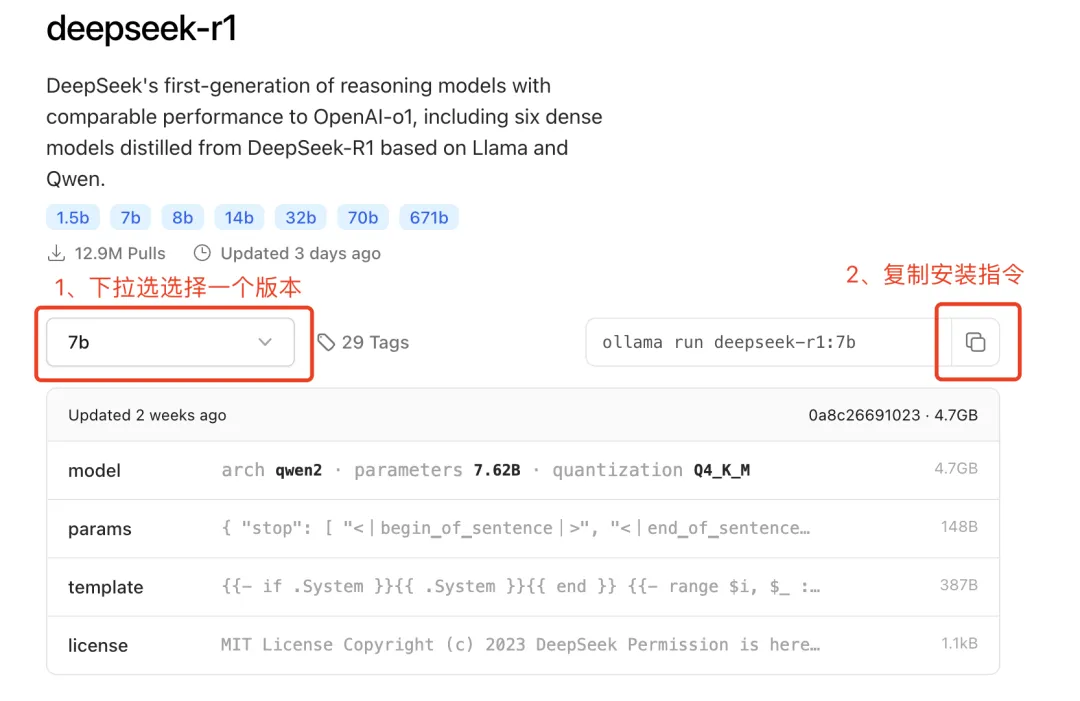

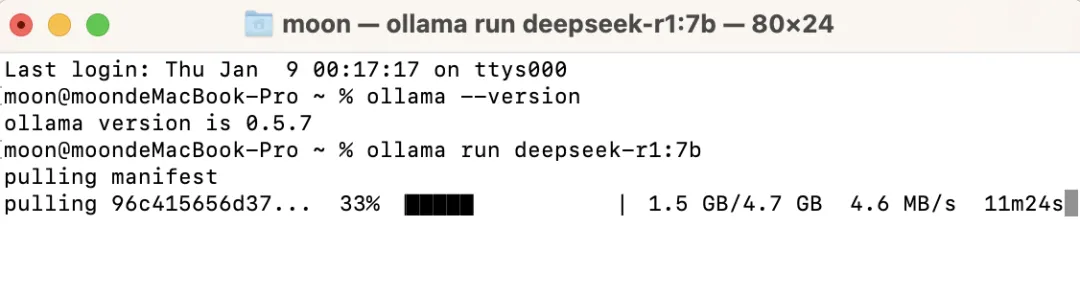

选择版本,复制安装指令粘贴到终端控制台中,点击回车,开始下载。

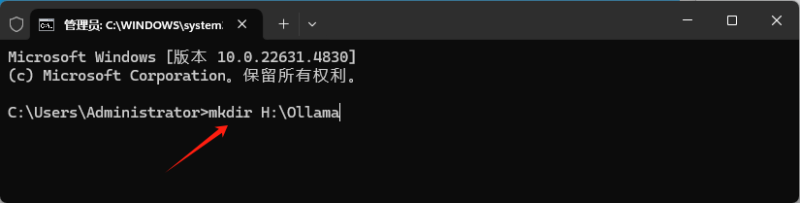

window电脑按下键盘上的win+R,调出运行窗口,输入cmd回车,调出命令行窗口粘贴:

macos直接启动台找到终端粘贴:

安装过程大概十几分钟,如果你卡一小时以上,或者一直不动,别纠结,考虑重下试试~

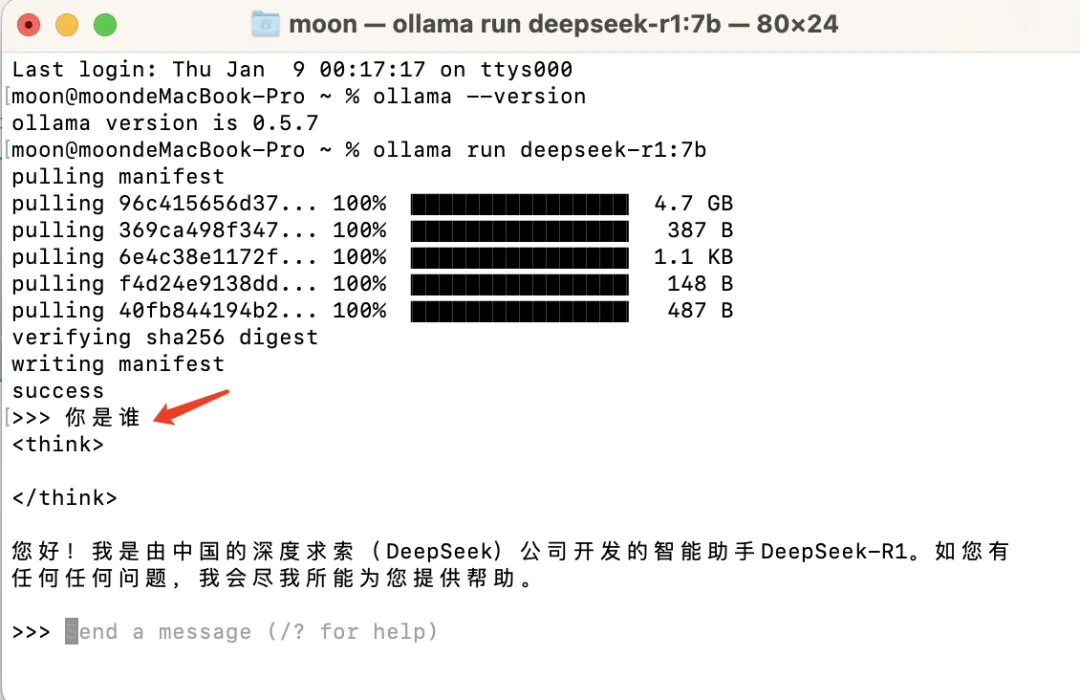

看到这个界面,恭喜你,说明你的deepseek安装成功了!就可以跟它对话了,我提问了“你是谁”:

但是一直在命令行里沟通是不是不够友好和方便,接下来我们安装可视化工具。

步骤三: 安装可视化工具: chatbox

是时候告别黑乎乎的命令行窗口了!咱们请出颜值担当->ChatBox客户端

官网直达:https://chatboxai.app

安装姿势:

点击「免费下载」后,解压后双击

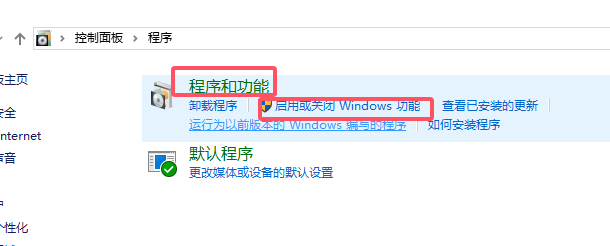

window电脑的话,自定义安装路径 (别放C盘!)

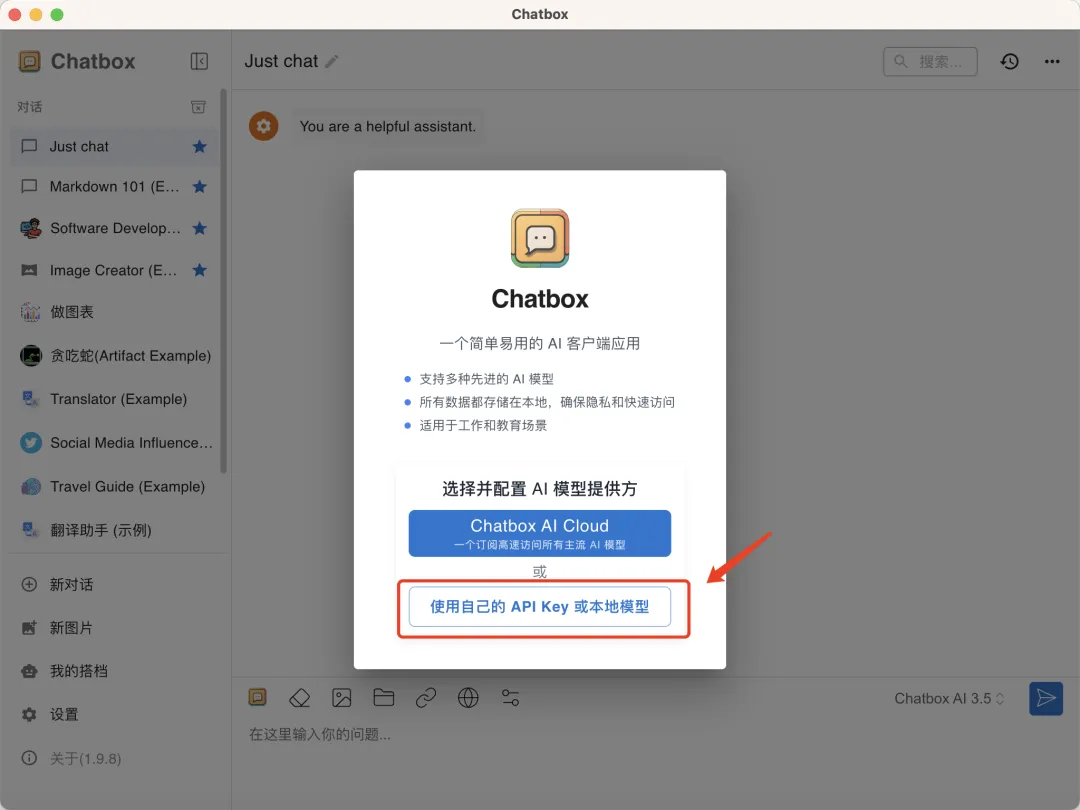

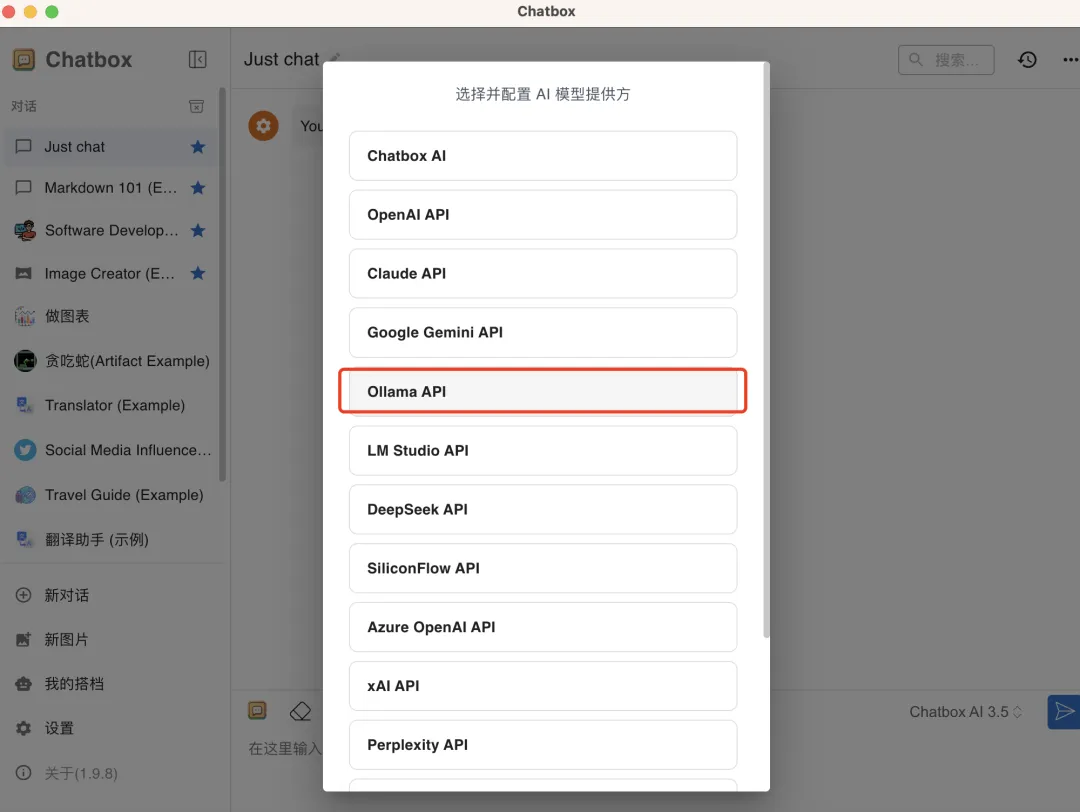

Chatbox安装好后,打开后,选择“使用自己的 API Key 或本地模型”

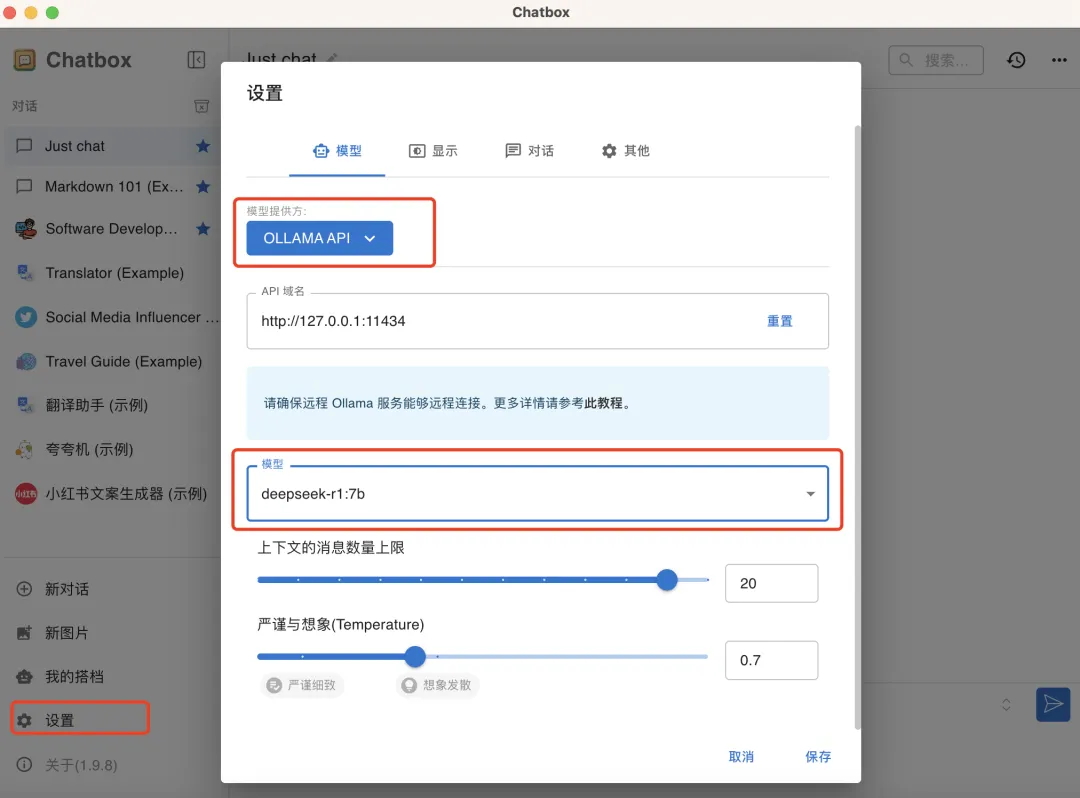

跳出的页面中设置好模型,选择Ollama API,最后选择我们已经安装好的deepseek模型就可以了。

页面如果不小心关闭了,也可以点击左下角的「设置」再次进入模型设置页面。

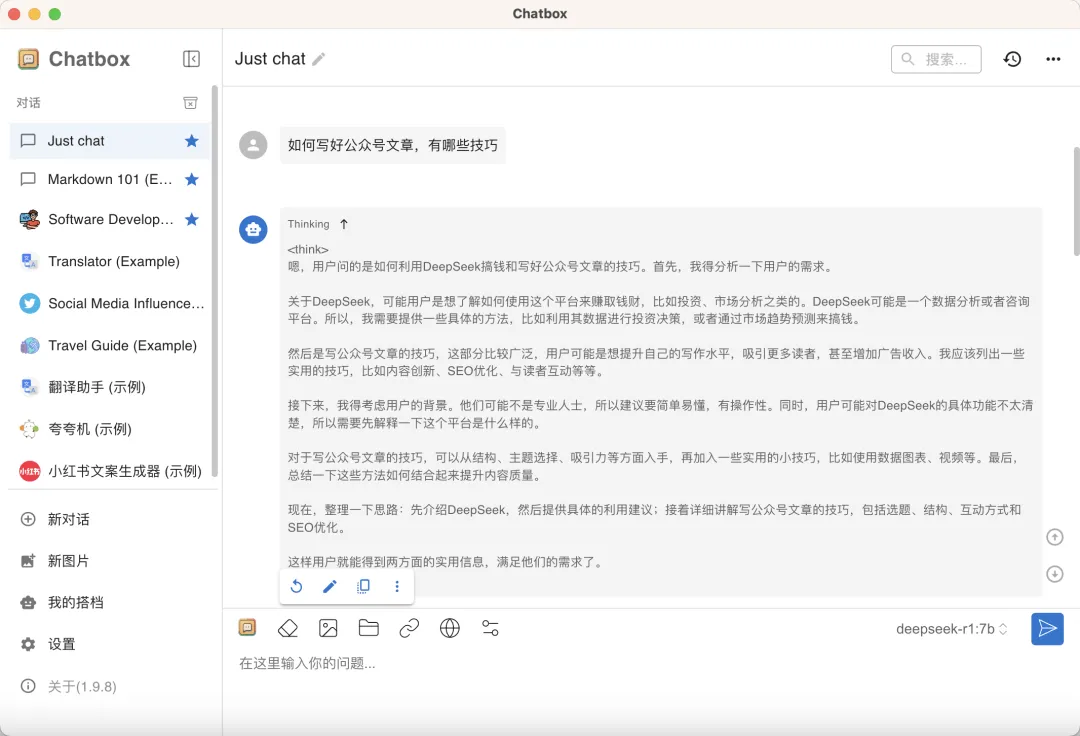

最后点击保存,可以在聊天窗口中,看到我们当前使用的大模型啦。

至此deepseek本地化部署就轻松地完成了!

- 本站素材解压密码:

7788 - 本站永久网址:https://mix688.com

- 内容声明:本网站文章部分内容来源于网络,仅供学习参考,如有侵权请联系站长微信ktc909删除处理

- 资源立场声明:本站资源不代表本站立场,不保证内容真实性

- 违法信息处理:禁止发布/转载违法信息,访客发现请向站长举报

- 资源存储声明:资源存储在云盘,链接失效请联系我们更新

![表情[xiaojiujie]-语义熔炉网](https://www.mix688.com/wp-content/themes/zibll/img/smilies/xiaojiujie.gif)

暂无评论内容