教程说明

1、大家可以根据本文档步骤安装使用。

2、看不懂文档的,可以看安装教程视频,跟着视频里一步一步操作。

deepseek本地部署视频教程:https://26794125.s21v.faiusr.com/58/ABUIABA6GAAg5L_cvQYouLD3hwI.mp4

3、如果怎么都搞不定,可以联系博主,远程手把手教你。一定要让你会部署!!!

配套资源

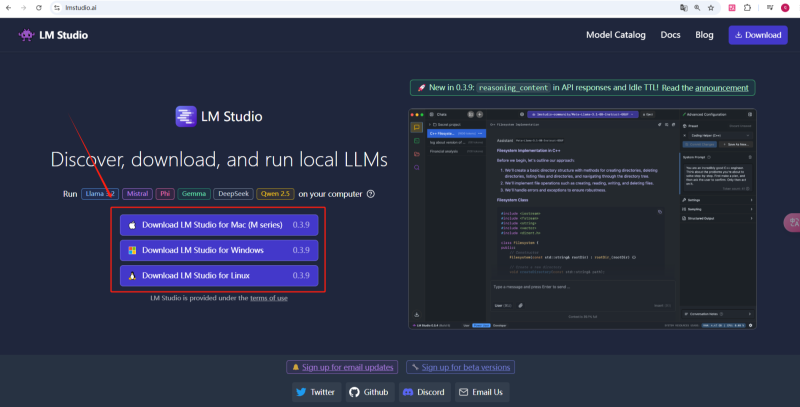

第一步:LM studio的下载安装

点击下载LM studio进行安装,安装至LM studio推荐的默认路径即可。

LM studio 下载地址:https://lmstudio.ai/

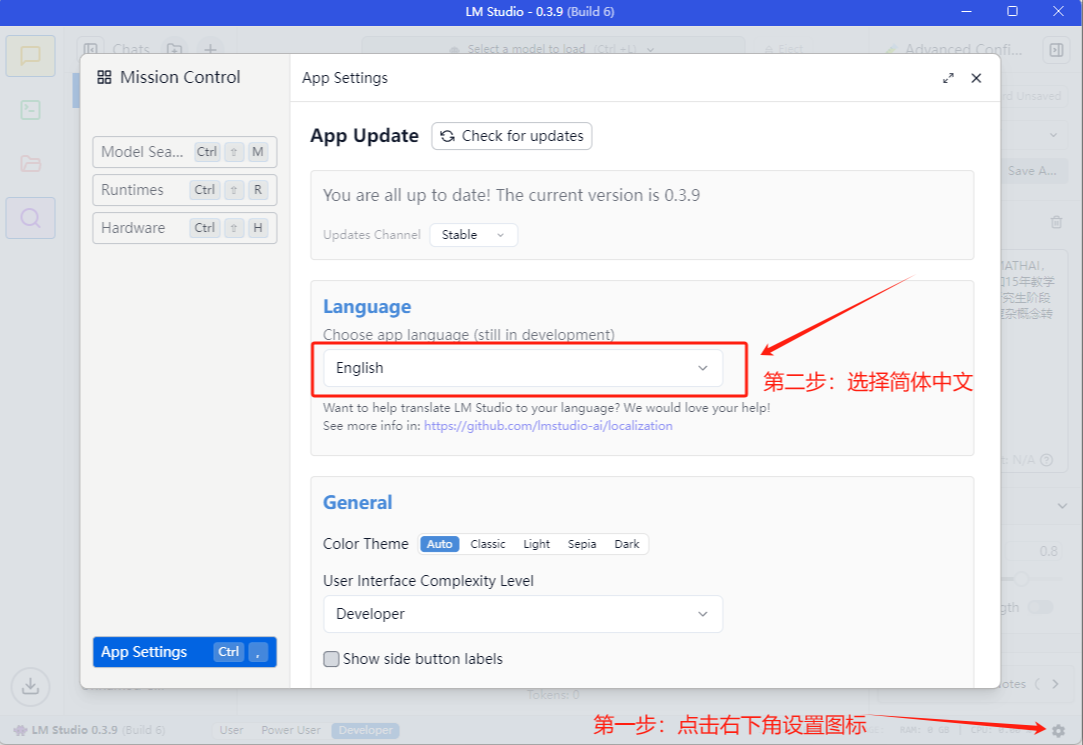

第二步:LM studio的配置

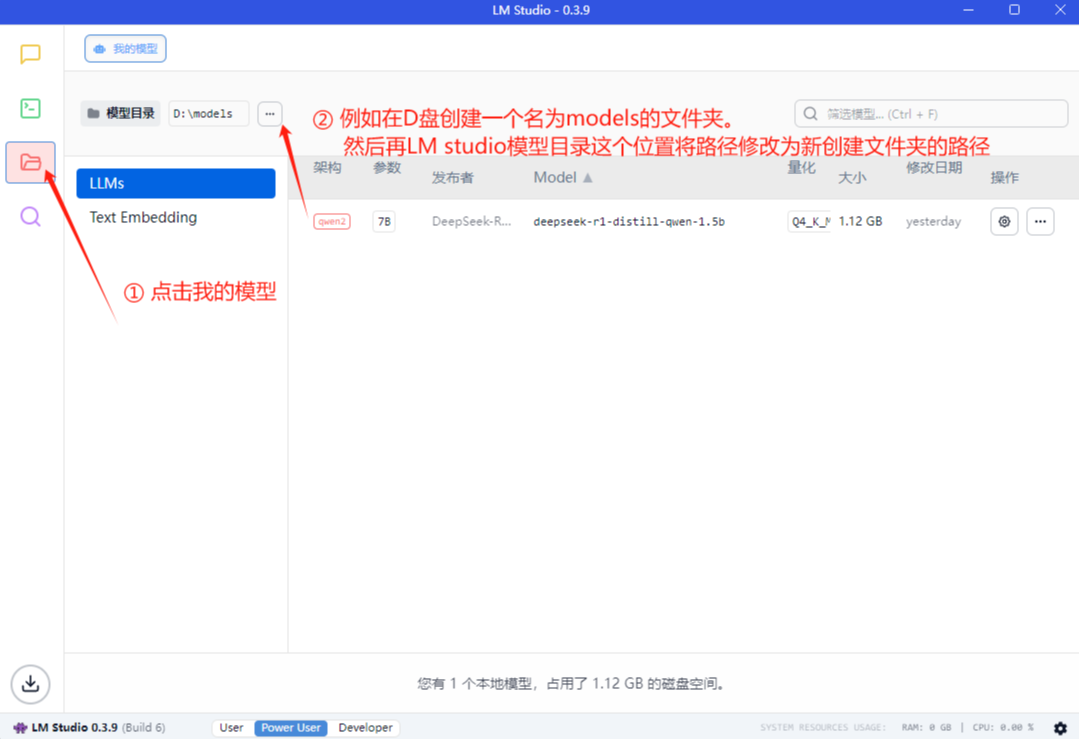

将界面配置为中文,并修改模型文件存储位置

1、点击右下角设置,改为简体中文。

第三步:DeepSeek模型选择和下载

第三步:DeepSeek模型选择和下载

根据博主的提供的参数,先清楚自己能够使用多大的模型,再进行下载。

根据自己电脑的显卡配置和需求选择合适的模型下载,可以先下载1个尝试,模型是可以下载多个并灵活切换的。

| 模型参数 | 模型精度 | 文件大小(以Q4为标准) | 显卡多大显存合适(以Q4为标准) |

|---|---|---|---|

| 1.5B | Q2/Q3/Q4/Q5/Q6/Q8 | 1.4GB | 4G – 6G |

| 7B | Q2/Q3/Q4/Q5/Q6/Q8 | 4.7GB | 8G – 12G |

| 8B | Q2/Q3/Q4/Q5/Q6/Q8 | 4.9GB | 8G – 12G |

| 14B | Q2/Q3/Q4/Q5/Q6/Q8 | 9.0GB | 12G – 16G |

| 32B | Q2/Q3/Q4/Q5/Q6/Q8 | 20GB | 16G – 24G |

| 70B | Q2/Q3/Q4/Q5/Q6/Q8 | 40GB | 24G – 48G |

| 671B | Q2/Q3/Q4/Q5/Q6/Q8 | 1.3TB | 80G以上 |

GPU算力对比图

- 博主实测,按照以上推荐的显存大小使用模型,推理速度相对较快。

- 采用博主推荐的 LM studio 软件可以控制推理模型时的电脑资源投入情况的,如果显存小,想要尝试大一些模型也可以,就是慢一些,并不是不能用。

- 另外使用 LM studio 软件就算没显卡也可以尝试 1.5B 的模型,用 CPU 进行计算,就是速度慢一些。

博主也在学习中,如果有问题,可以找博主交流,共同进步!!!

以下是闭住制作的显卡参数,不知道自己显卡显存和算力多少的,可以查看

| 显卡型号 | 显存(版本) | CUDA核心数 | 算力 |

|---|---|---|---|

| GTX1050TI | 4G | 768 | 2.4 TFLOPS |

| GTX1060 | 3G | 1152 | 4.4 FLOPS |

| GTX1060 | 6G | 1280 | 4.4 FLOPS |

| GTX1070TI | 8G | 2432 | 6.5 FLOPS |

| GTX1070TI | 11G | 2432 | 6.5 FLOPS |

| GTX1080 | 8G | 2560 | 8.9 FLOPS |

| GTX1080TI | 11G | 3584 | 11.3 FLOPS |

| GTX1650 | 4G | 896 | 3.0 FLOPS |

| GTX1660super | 6G | 1408 | 5.0 FLOPS |

| RTX2060 | 6G | 1920 | 6.5 FLOPS |

| RTX2060Super | 8G | 2176 | 7.0 FLOPS |

| RTX2070 | 8G | 2304 | 7.5 FLOPS |

| RTX2070Super | 8G | 2560 | 8.1 FLOPS |

| RTX2080 | 8G | 2944 | 10.0 FLOPS |

| RTX2080Super | 8G | 3072 | 11.0 FLOPS |

| RTX2080Ti | 11G | 4352 | 13.4 FLOPS |

| RTX3060 | 8G | 3584 | 13.0 FLOPS |

| RTX3060 | 12G | 3584 | 13.0 FLOPS |

| RTX3060Ti | 8G | 4864 | 16.2 FLOPS |

模型下载地址(网盘链接+官方备用链接)

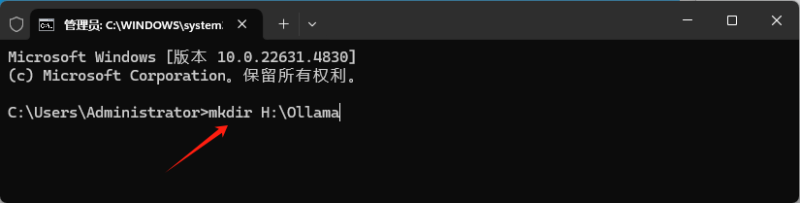

第四步:保存模型到文件夹将模型保存在我们在第二步时创建的D盘models文件夹下。

按着下面视频操作即可

1、在保存模型时, 要先创建一个文件夹, 文件夹名称和模型名称一致, 然后将模型拉进这个文件夹内.

2、再新建一个文件夹, 文件夹名称改短一些, 将上一个文件夹再放进入新文件夹即 可.

备注:通过夸克或百度网盘下载的模型, 主播已经套好文件夹了, 只需要保存在D盘models文件夹下即可.

第五步:打开LM studio加载模型 进行对话到这里就已经搞定了呢,我们可以开始愉快的使甩了!!!点击加载模型,与AI进行对话。

第六步:利用LM studio生成API进行调用除了直接在LM studio上进行对话,我们还可以通过生成API来供本地开发使用,端口是和Open AI一样的标准! 点击加载模型,与AI进行对话。

- 本站素材解压密码:

7788 - 本站永久网址:https://mix688.com

- 内容声明:本网站文章部分内容来源于网络,仅供学习参考,如有侵权请联系站长微信ktc909删除处理

- 资源立场声明:本站资源不代表本站立场,不保证内容真实性

- 违法信息处理:禁止发布/转载违法信息,访客发现请向站长举报

- 资源存储声明:资源存储在云盘,链接失效请联系我们更新

![表情[xiaojiujie]-语义熔炉网](https://www.mix688.com/wp-content/themes/zibll/img/smilies/xiaojiujie.gif)

暂无评论内容