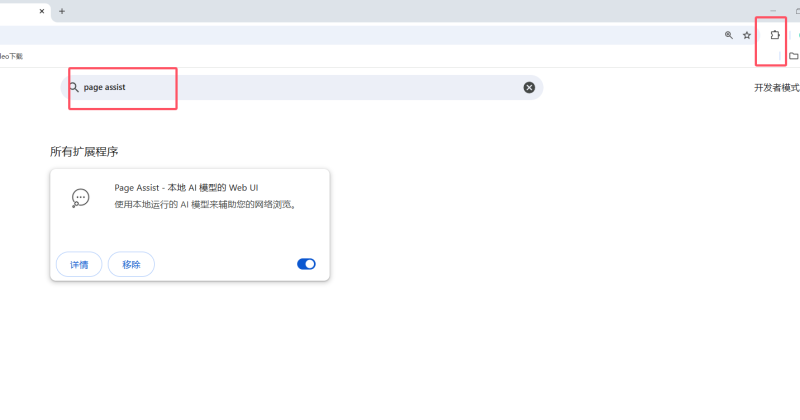

LM Studio 和 Ollama 都是用于本地运行大型语言模型(LLM)的工具,但它们在设计目标、使用方式和适用场景上有显著区别。以下是两者的详细对比:

1. 核心定位

| 特性 |

LM Studio |

Ollama |

| 目标用户 |

普通用户、研究者(注重图形界面交互) |

开发者、技术爱好者(注重命令行和 API 集成) |

| 核心功能 |

提供 GUI 界面,支持聊天式交互和模型实验 |

通过命令行/API 管理模型,支持多模型服务化部署 |

| 开源 |

❌ 闭源 |

✅ 开源 |

2. 使用方式对比

LM Studio

- 图形界面(GUI):

提供直观的聊天窗口、模型切换、参数调整(如温度、最大 token 数等),适合非技术用户。

- 模型管理:

直接下载 Hugging Face 上的 GGUF 格式模型,支持本地模型加载。

- 交互模式:

类似 ChatGPT 的对话体验,支持对话历史保存和导出。

Ollama

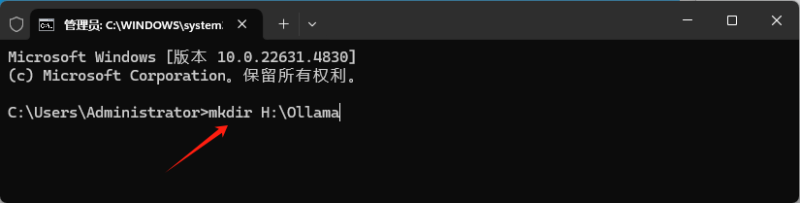

- 命令行(CLI):

通过终端命令操作(如 ollama run llama2),适合开发者或熟悉命令行的用户。

- 服务化部署:

可作为后台服务运行(默认端口 11434),提供 REST API 供其他应用调用。

- 模型库管理:

内置官方模型库(如 LLaMA、Mistral),支持自定义 Modelfile 构建私有模型。

3. 模型支持

| 特性 |

LM Studio |

Ollama |

| 模型格式 |

仅支持 GGUF 格式(需手动下载) |

支持 GGUF 和自有格式,可直接拉取预置模型 |

| 模型来源 |

依赖用户从 Hugging Face 等平台手动下载 |

官方提供精选模型库,也支持自定义导入 |

| 多语言支持 |

依赖加载的模型(如中文需下载特定模型) |

同左,但官方库对中文模型支持较少 |

4. 部署与集成

| 特性 |

LM Studio |

Ollama |

| 本地运行 |

✅ 单机运行,适合个人实验 |

✅ 支持单机运行,也可作为服务供多终端访问 |

| API 支持 |

❌ 无原生 API |

✅ 提供 REST API,方便集成到其他应用 |

| 跨平台 |

✅ Windows/macOS |

✅ Windows/macOS/Linux |

| Docker 支持 |

❌ |

✅ 官方提供 Docker 镜像,支持 GPU 加速 |

5. 性能与资源

| 特性 |

LM Studio |

Ollama |

| GPU 加速 |

✅ 自动启用(需 NVIDIA 显卡) |

✅ 需手动配置 CUDA/ROCm |

| 多模型并发 |

❌ 单模型运行 |

✅ 可同时加载多个模型 |

| 内存管理 |

需手动关闭模型释放资源 |

支持通过参数限制内存占用(如 OLLAMA_MAX_LOADED_MODELS) |

6. 典型使用场景

LM Studio

- 个人快速体验不同模型(如 Mistral、CodeLlama)。

- 需要图形界面调整参数、保存对话历史。

- 非技术用户想免代码运行本地模型。

Ollama

- 开发者需要将 LLM 集成到应用中(通过 API)。

- 多模型管理或长期运行模型服务。

- 结合 Docker/Kubernetes 实现云原生部署。

7. 如何选择?

- 选 LM Studio:

如果你想要「开箱即用」的聊天式交互,注重图形界面和易用性,且不需要 API 集成。

- 选 Ollama:

如果你需要 API、多模型服务化部署,或计划将 LLM 与其他开发工具(如 LangChain)结合使用。

![表情[xiaojiujie]-语义熔炉网](https://www.mix688.com/wp-content/themes/zibll/img/smilies/xiaojiujie.gif)

暂无评论内容