目的

使用ollama + pageassist + deepseek大模型,实现局域网内访问本地部署的大模型,手机也能畅快问答。

使用LmStudio + deepseek + vscode(continue) ,实现低配置电脑也可快速生成代码。

1. ollama + pageassist 手机访问本地deepseek

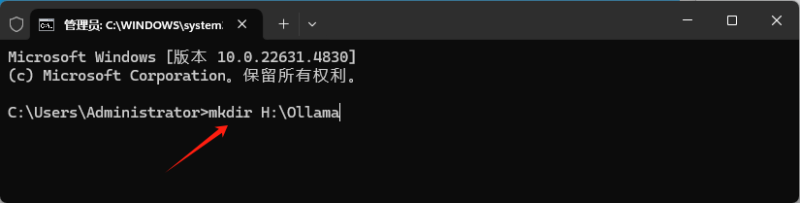

1.1 安装ollama

ollama 官网:https://ollama.com/ 下载ollama安装包。如果你下载过慢,可进入右上角Q群文件中直接获取安装包。

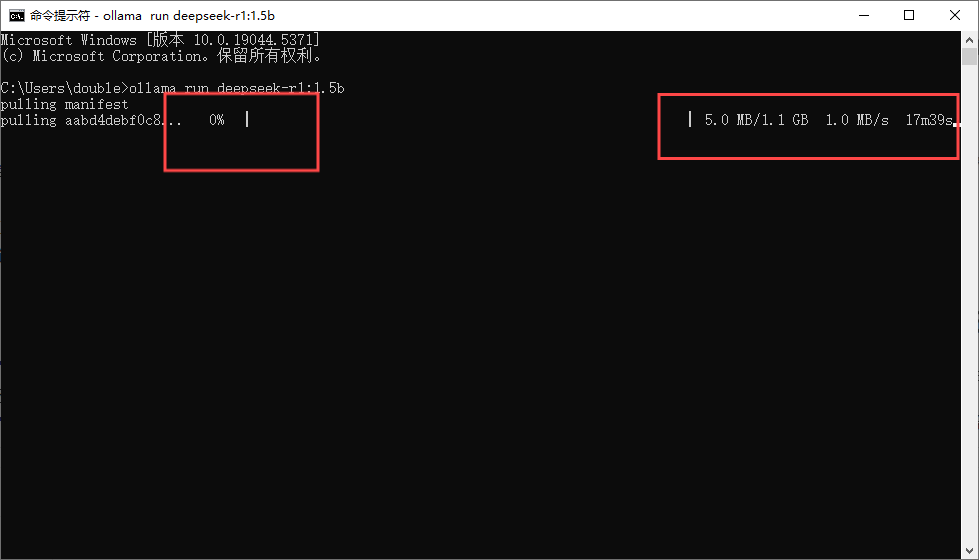

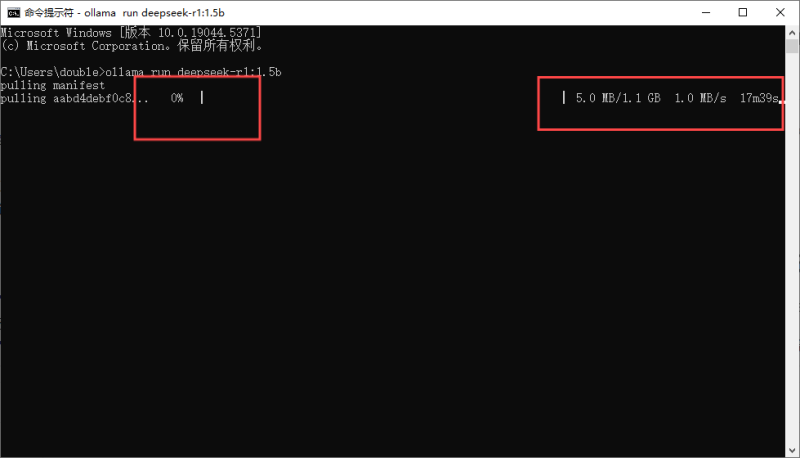

安装完成后,在开始菜单处搜索cmd,打开命令行窗口,输入以下命令下载DeepSeek:

ollama run deepseek-r1:1.5b

屏幕出现sucssese字样表示下载完成并载入运行deepseek

1.2 手机端下载火狐浏览器

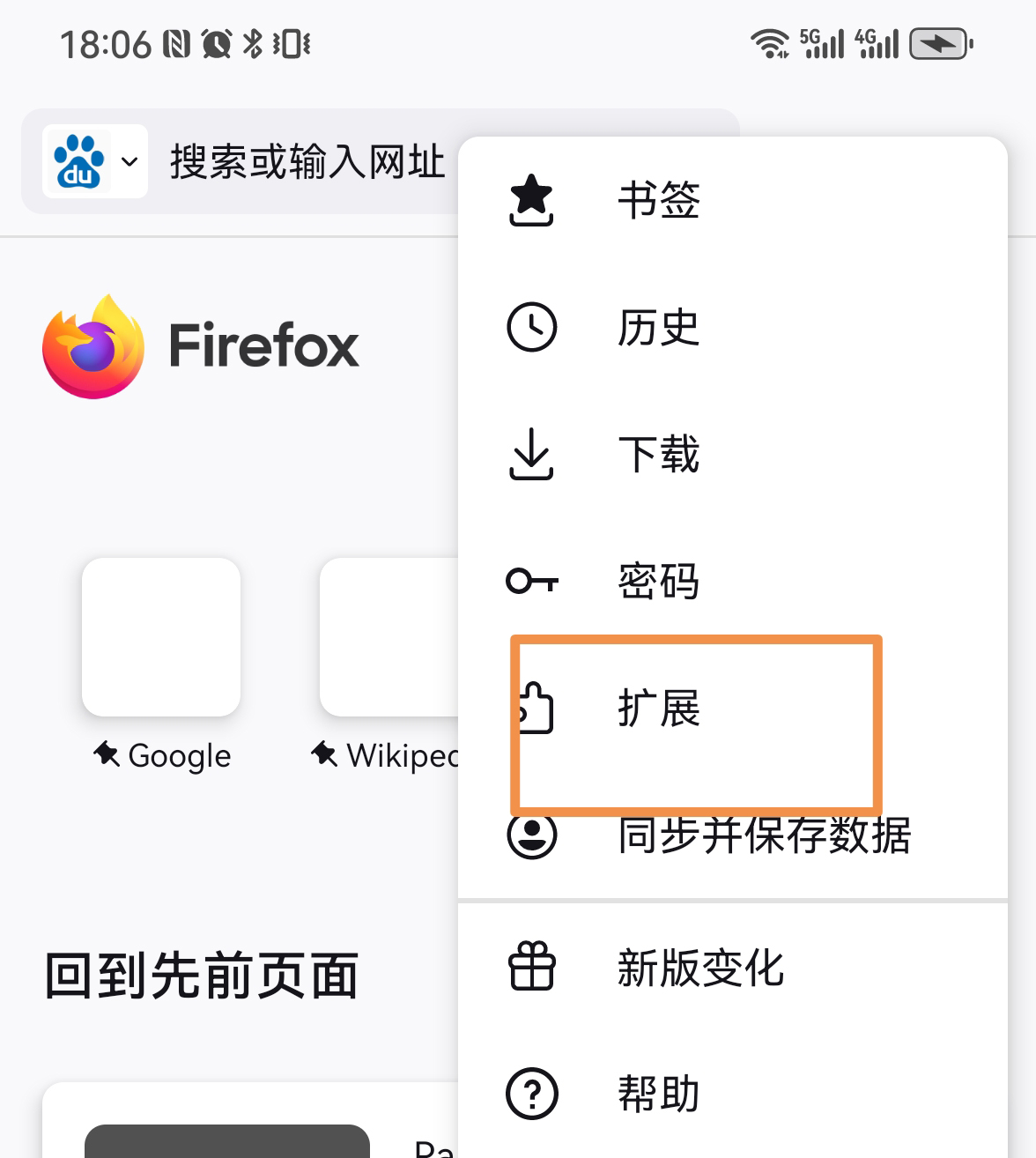

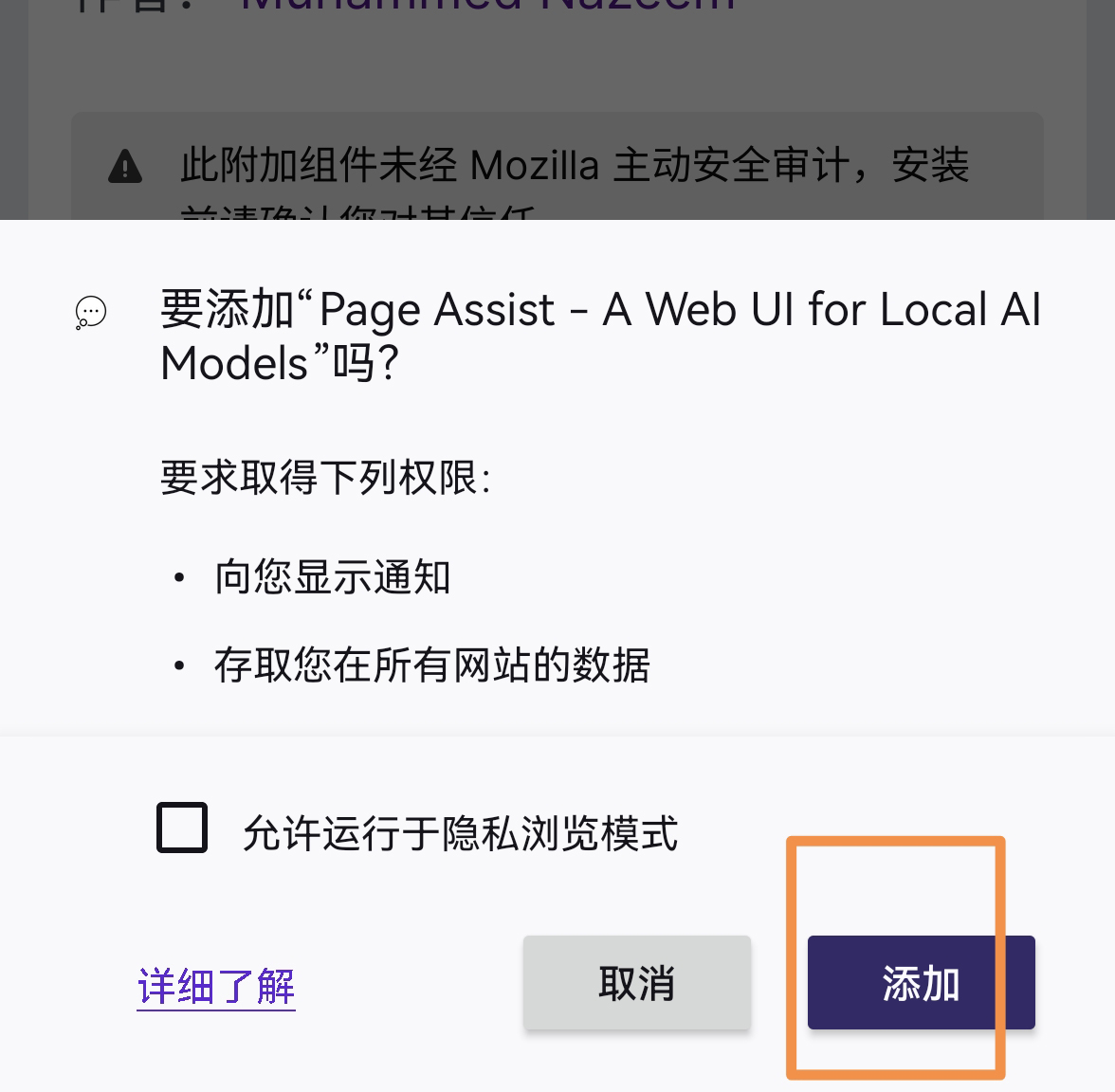

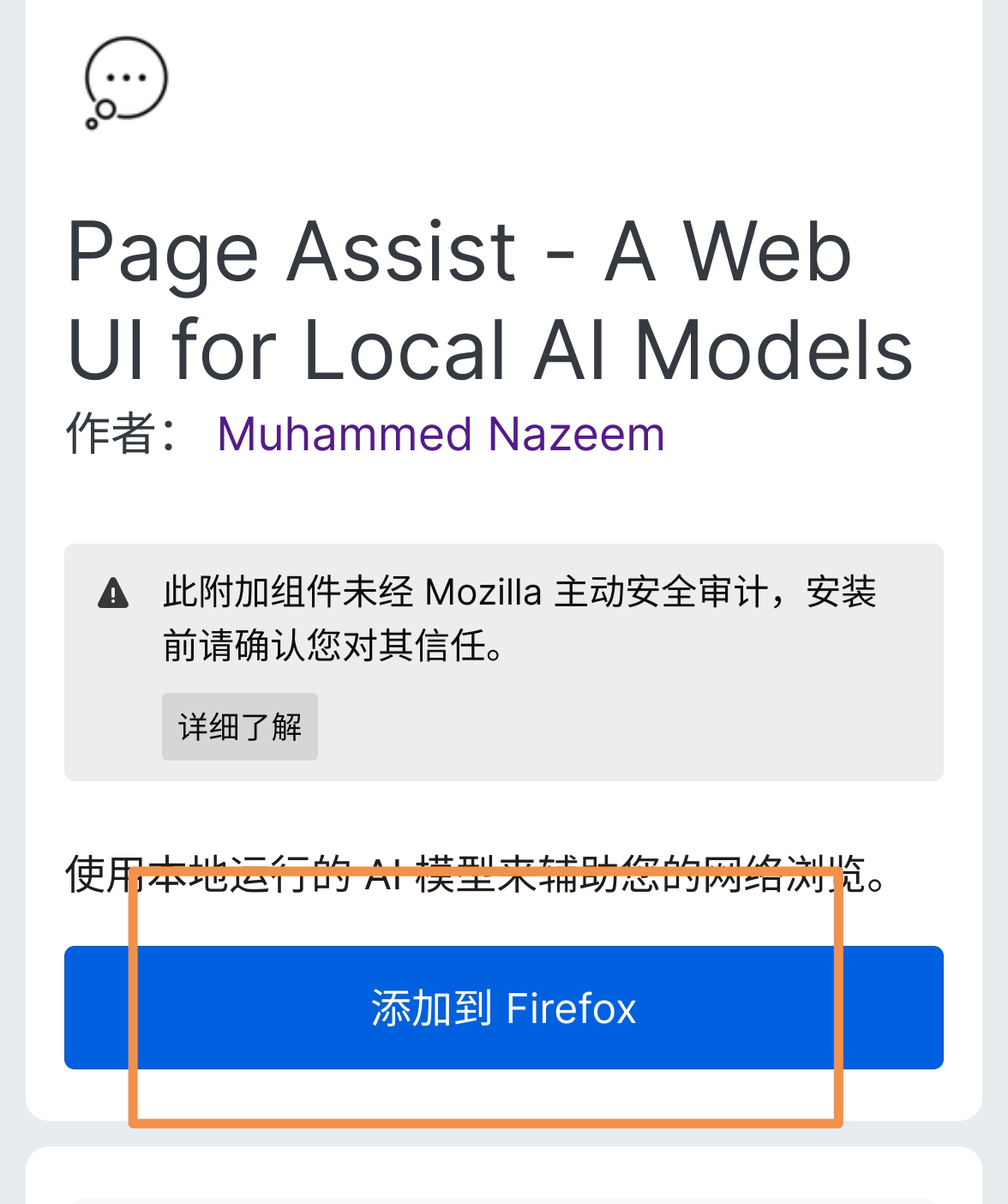

在任意手机应用市场搜索火狐浏览器,下载完成后,打开火狐浏览器,点击屏幕右上角...,,点击拼图图标,跳转页面后,向下翻至寻找更多更多拓展搜索安装pageassist插件,稍作等待即可安装完毕后,点击添加。

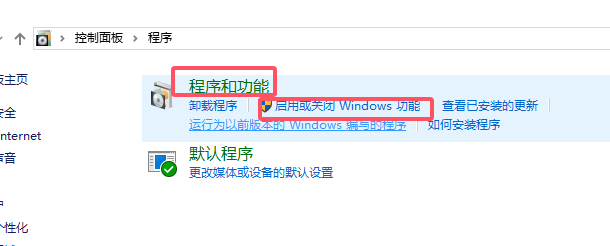

1.3 配置运行环境

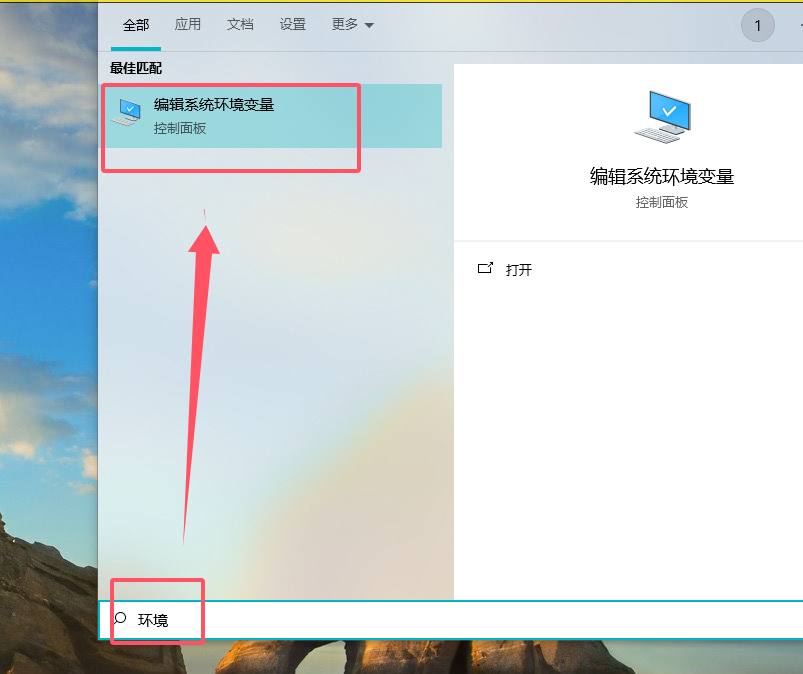

在电脑左下角,点击搜索图标,搜索环境,或通过其他方式打开环境配置:

在 点击 系统变量 选项,在系统变量 或 用户变量下新建一个名为OLLAMA_HOST,值为.0.0.0的变量:

点击确定保存变量,然后在屏幕右下角关闭ollama,在应用中找到它并重启。

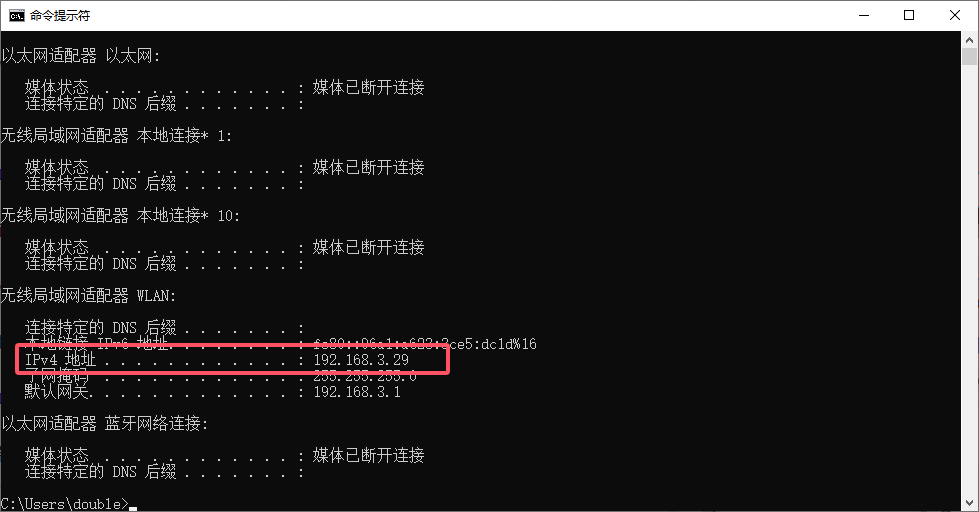

1.4 获取本机局域网内ip地址

在电脑上打开cmd,输入ipconfig命令,查看本机局域网内ipv4地址:

本机地址为192.168.3.29

1.5 手机端访问本地deepseek

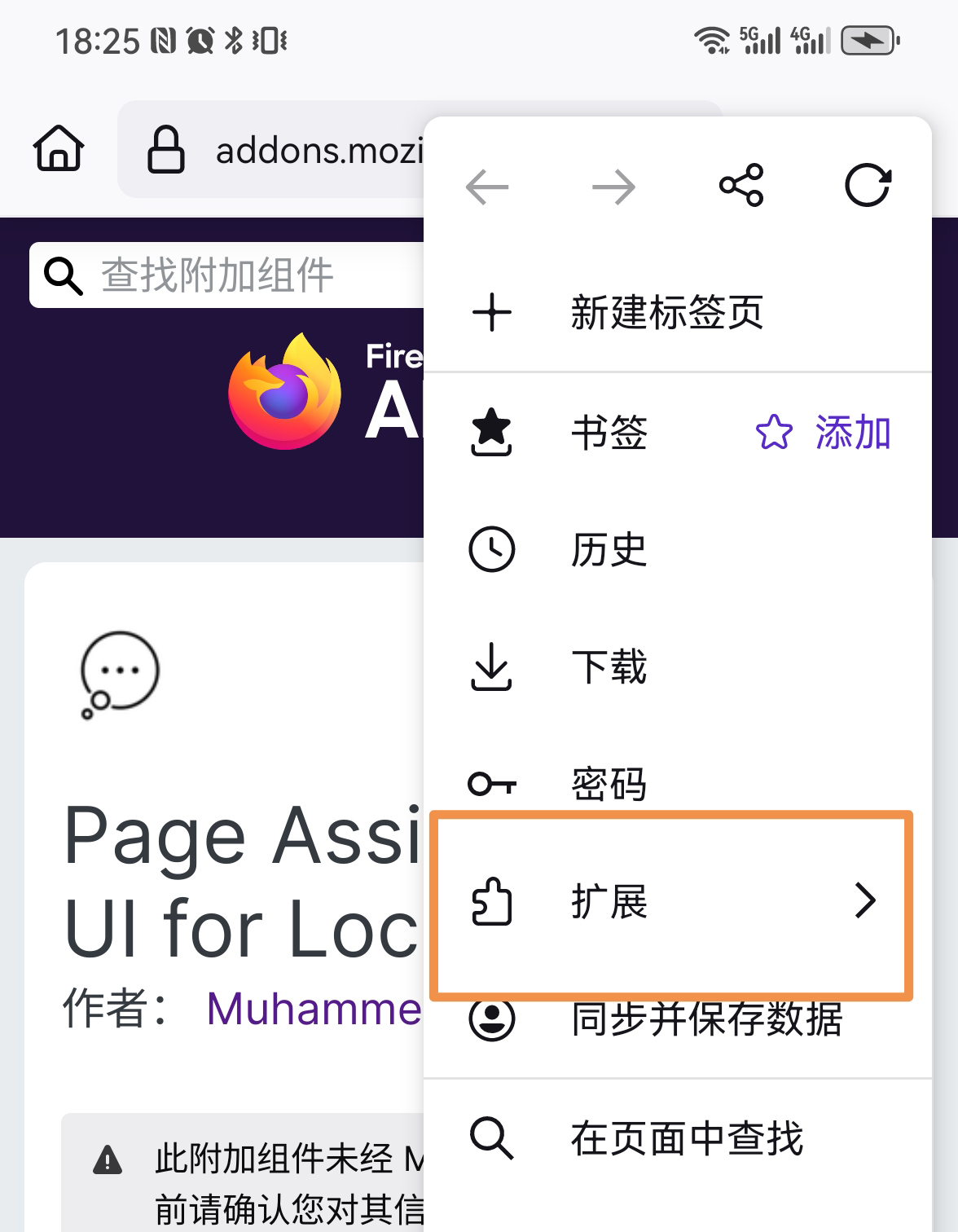

手机端打开火狐浏览器,在任意一个新访问的页面下(默认主页不可以),点击屏幕右上角...,选择拓展图标,点击进入paga assist拓展应用界面。

修改ollama访问url

进入后,将url修改为http://192.168.3.29:11434

点击retry按钮,显示ollama is running表示链接成功。

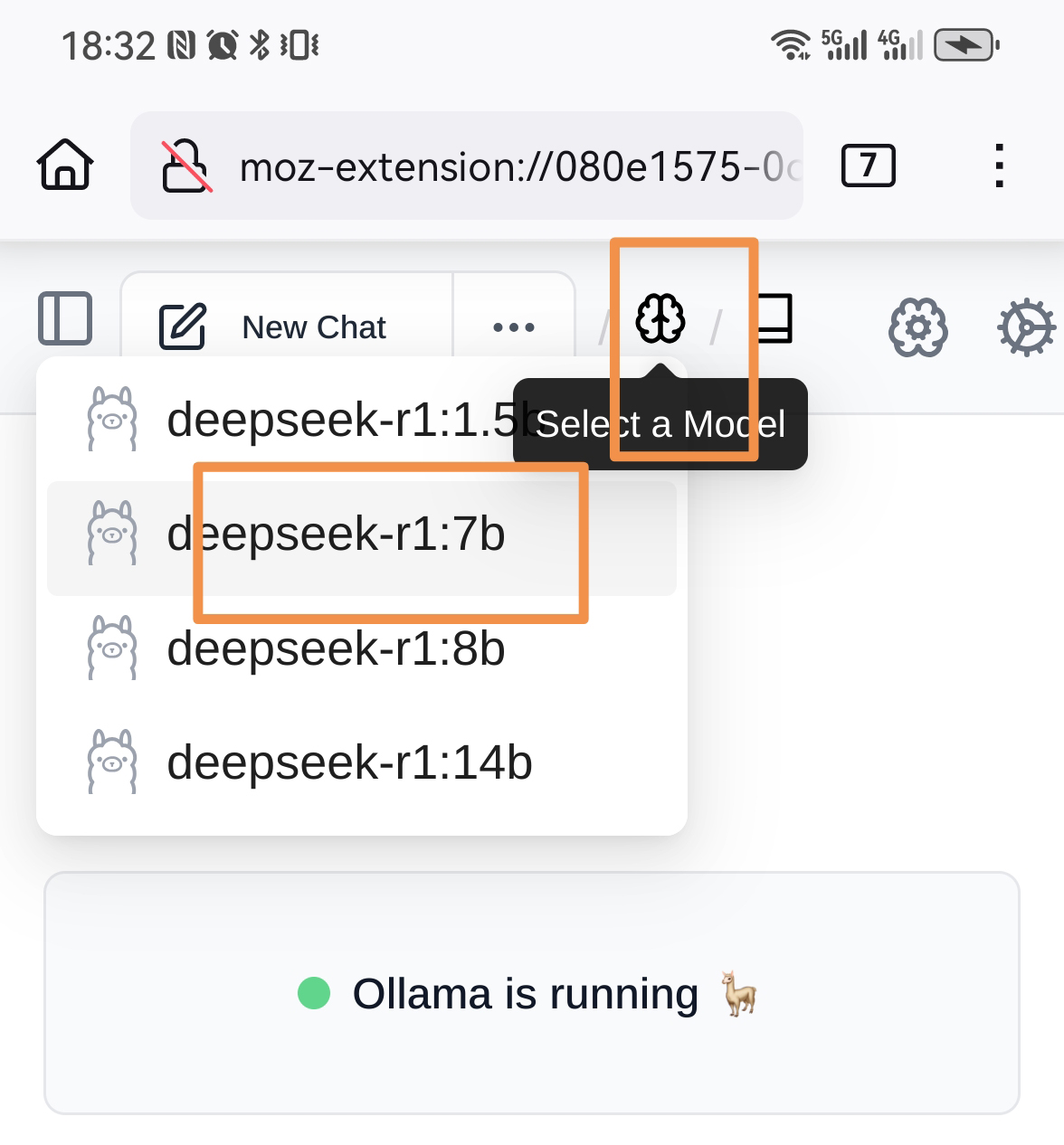

修改模型

点击大脑图标选择模型,此时你就可以在手机上访问你的大模型了。

2. LmStudio + vscode 低配置电脑生成代码

2.1 安装LmStudio

LmStudio安装及部署大模型的教程请参考:https://eogee.com/article/detail/10

2.2 启动运行时

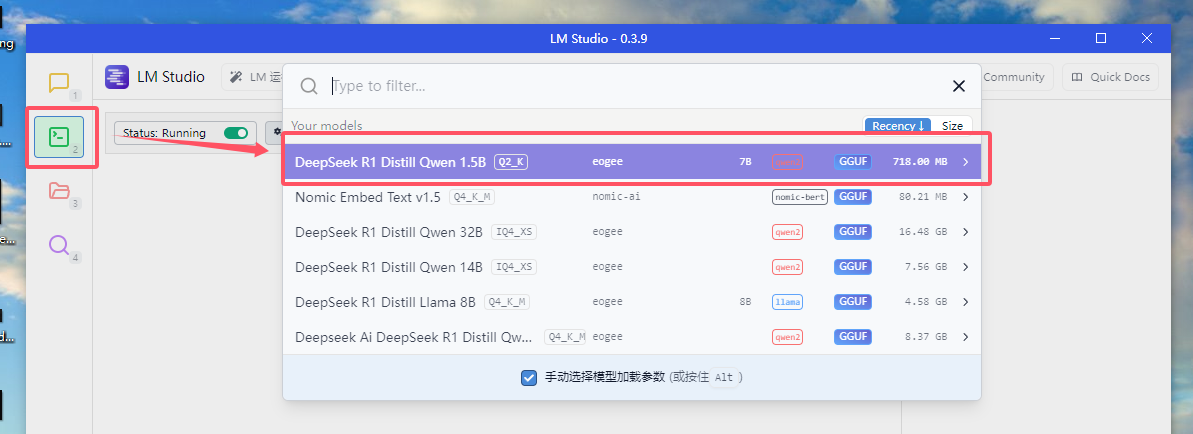

打开LMstudio后,点击左上角的 第二个 图标 ,进入运行时设置界面,点击上方下拉框 选择要载入的模型。

载入模型

点击右下角 加载模型 稍作等待后,开始开启运行时。

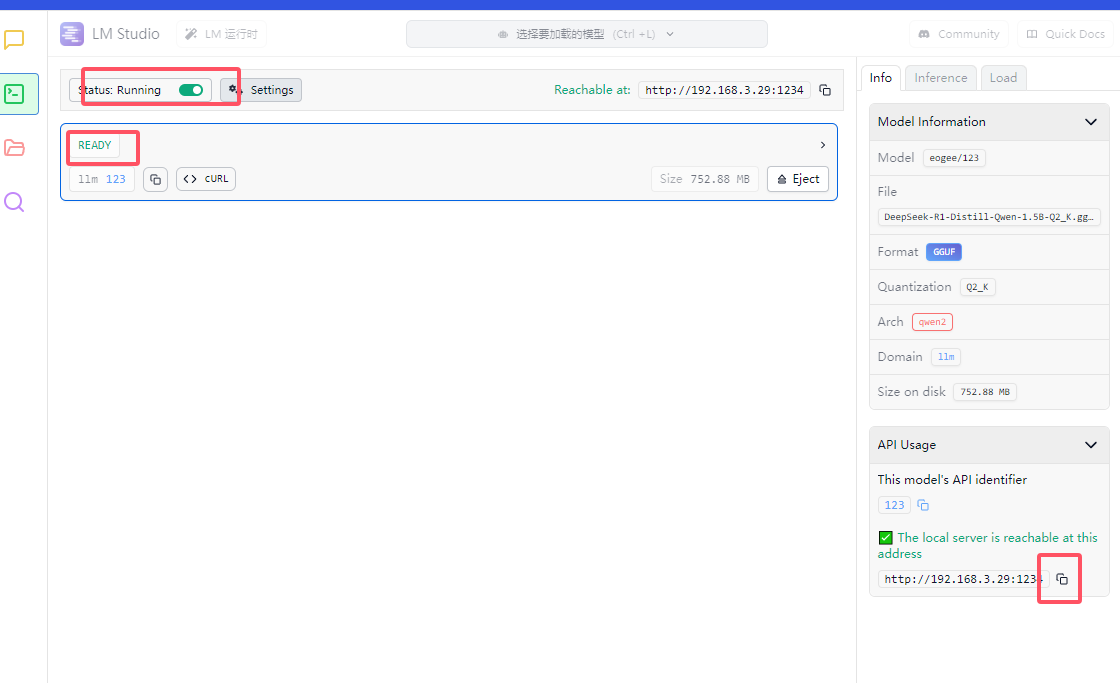

开启运行时 获取本地服务IP

将 status running 开关打开为 绿色 ,并去报下方为 ready 状态。

点击右下角 The local sever 下方的 复制 按钮,复制服务IP。

2.3 下载安装vscode及continue插件

此内容需要使用vscode的中的continue插件,请先安装vscode,并安装continue插件。相关教程参照:不付费生成代码:VSCode与DeepSeek结合实现

2.4 修改config.json文件

我们需要在选中LmStudio作为模型提供者时,将LmStudio的服务IP配置到vscode的config.json文件中。具体配置如下:

由于需要跨设备,这里就不给大家演示了。

3.说明

- 多设备链接会造成一定的性能下降

- 如实现内网穿透理论上任意设备都可访问本地部署的大模型

- AnythingLLM的局域网访问需进一步测试,有结果后会及时和大家汇报

- 大家也可以尝试使用其他工具解锁更多可能

- 本站素材解压密码:

7788 - 本站永久网址:https://mix688.com

- 内容声明:本网站文章部分内容来源于网络,仅供学习参考,如有侵权请联系站长微信ktc909删除处理

- 资源立场声明:本站资源不代表本站立场,不保证内容真实性

- 违法信息处理:禁止发布/转载违法信息,访客发现请向站长举报

- 资源存储声明:资源存储在云盘,链接失效请联系我们更新

![表情[xiaojiujie]-语义熔炉网](https://www.mix688.com/wp-content/themes/zibll/img/smilies/xiaojiujie.gif)

暂无评论内容