1. 目的

投喂数据使得我们的模型在专业领域中更加聪明。

更新模型中的原有数据库,时期获得最新领域动态。

一定程度的续写能力,让它更具有创造性。

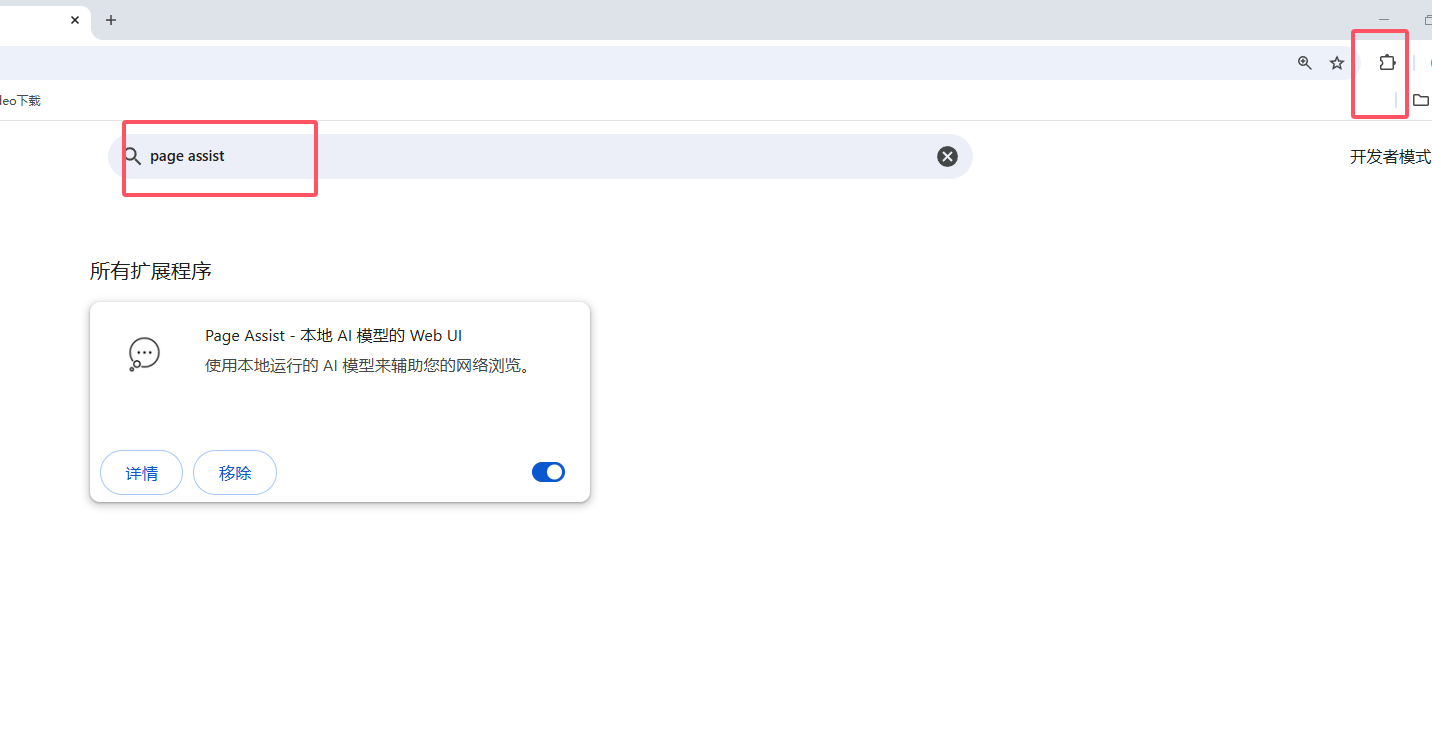

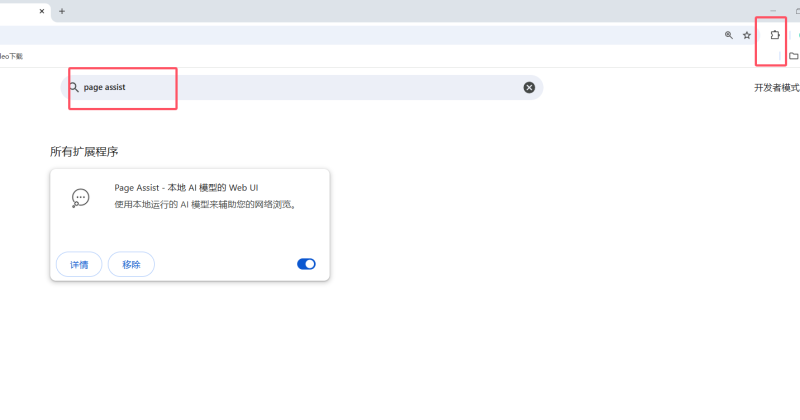

2. 准备 page assist chrome 插件 或 firefox 插件

在浏览器上述两个任意浏览器中的拓展应用中心中搜索 page assist 点击添加安装。

3.联网检索

打开左上角的设置,在第一项 一般设置 中向下翻,找到搜索引擎设置,选择搜索引擎为sougou(其他非科学上网的情况下,不好用),点击保存。

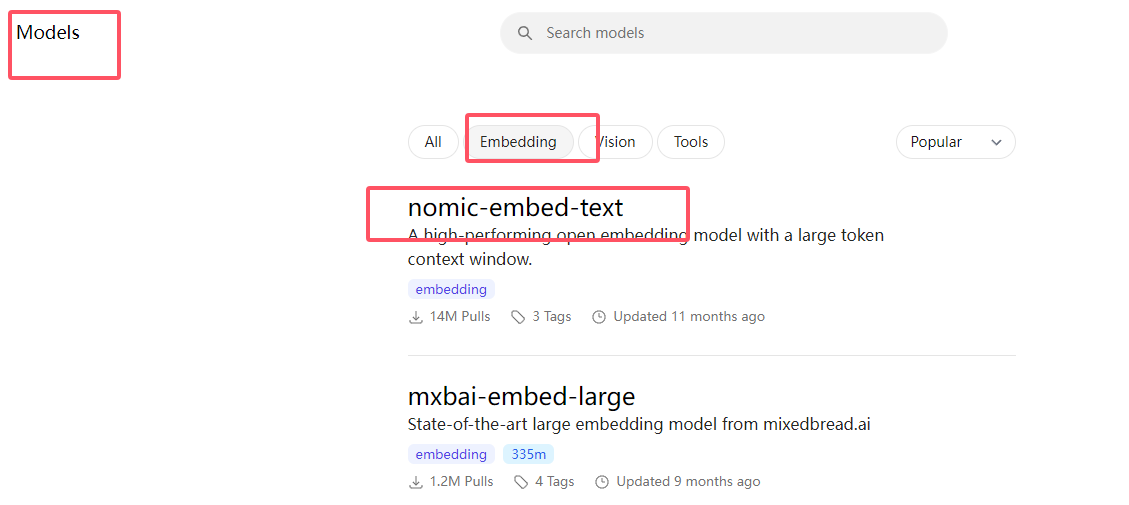

3.下载数据处理模型

在ollama的官网,找到 models , embeding 复制第一或第二个模型名称旁的命令。

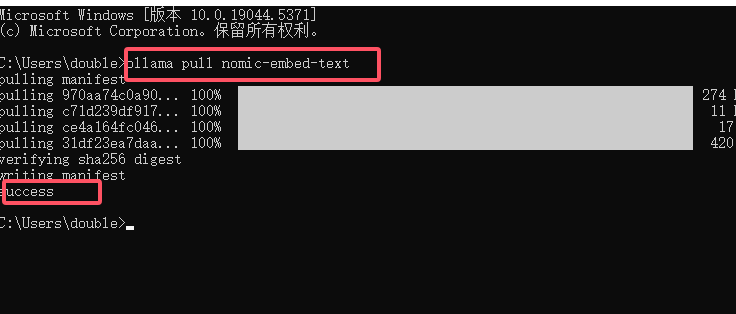

然后在 cmd 输入命令,如:

ollama pull nomic-embed-text

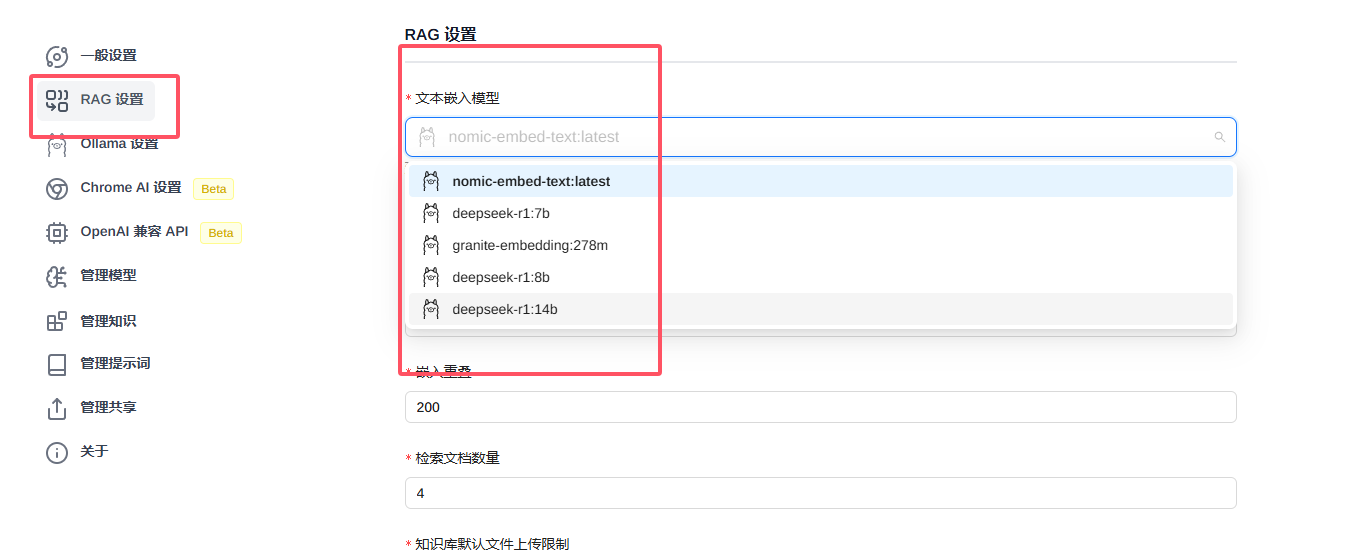

待下载完成后,回到pageassist中,点击右侧设置图标,在左侧菜单中找到 RAC 设置 ,在第一个下拉选项选择你刚下好的处理模型并保存。

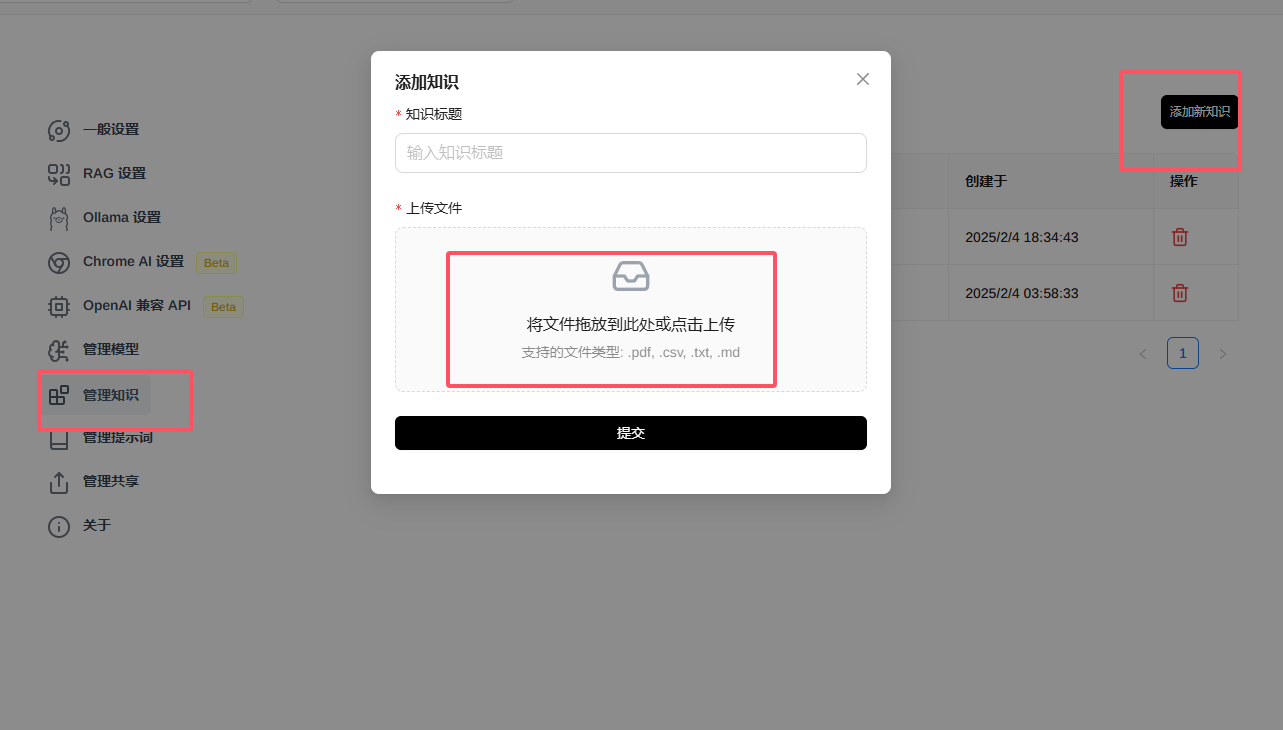

4.投喂数据

在pageassist中,点击左侧知识管理,在右侧表单提交知识内容,可以选择txt md pdf格式的内容,vsc格式有识别不到内容的情况发生。

提交内容可以一次提交多个文件,没已批次提交的内容即为一个类型的知识库。

可以在下面的设置中设置一次性提交文件的数量,模型同时检索采纳的文件数量。

在提交后,会有 处理中(数据向量化) 字样 处理成功后,返回聊天界面,测试效果。

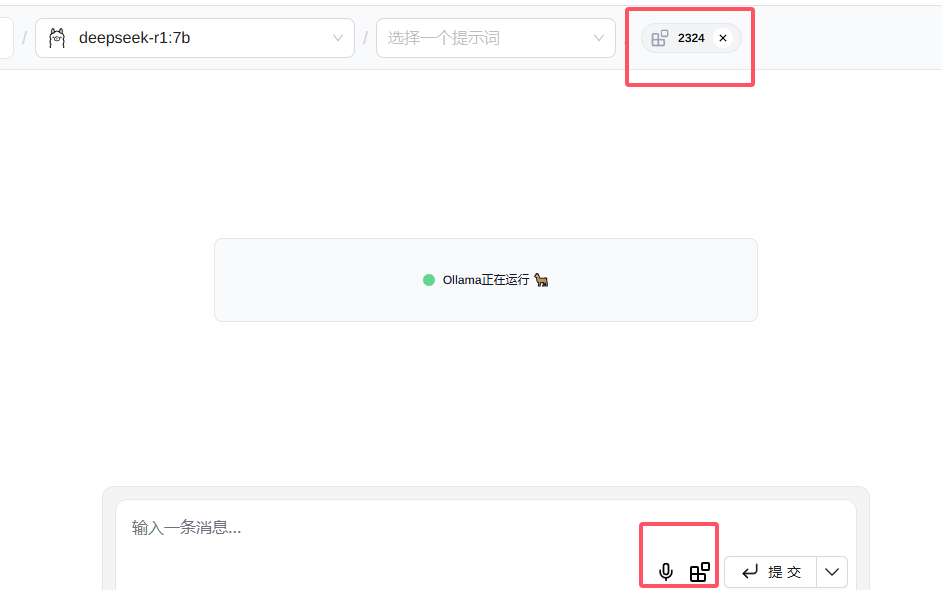

5.测试效果

在聊天界面,输入你想搜索的内容,在提交前,点击 知识 图标,提交后,模型会基于你提交的知识库内容的内容作出回复。

比如:

我们提交一篇2024美国大选结果的新闻作为知识内容,由于模型内既有数据是不包括该结果的,在投喂前,模型是无法给出正确答案的。

当我们投喂并带着投喂的知识内容进行提问,模型会为我们提供相关的答案。

6应用场景

- 个人应用:快速对比,快速检索,快速学习,快速解决问题。

- 企业应用:专有内容库、专业领域智能客服

- 教育应用:专有知识库

可能的应用场景还有很多,大家可以多多尝试。

7. 注意事项

- 模型加载知识库内容会降低推理效率,注意合理利用本地硬件资源

- 部分场景下,要对知识库的及时更新

- 联网搜索功能和检索本地知识库,在page assist 中只能同时使用一种

8. 下节预告

如果你使用的是LM studio 部署,使用anythingLLM 投喂数据。

关于我

关于我,半个程序员,实战派和落地派,主要追求提升效率和具体场景的问题解决,不搞噱头,不搞营销,欢迎大家关注或加入交流群。

- 本站素材解压密码:

7788 - 本站永久网址:https://mix688.com

- 内容声明:本网站文章部分内容来源于网络,仅供学习参考,如有侵权请联系站长微信ktc909删除处理

- 资源立场声明:本站资源不代表本站立场,不保证内容真实性

- 违法信息处理:禁止发布/转载违法信息,访客发现请向站长举报

- 资源存储声明:资源存储在云盘,链接失效请联系我们更新

![表情[xiaojiujie]-语义熔炉网](https://www.mix688.com/wp-content/themes/zibll/img/smilies/xiaojiujie.gif)

暂无评论内容